隨著全球企業對WhatsApp營銷需求激增,如何設計穩定支援10萬賬號並發的雲控系統成為技術挑戰。數據顯示,2023年企業級WhatsApp API請求量同比增長210%,但高併發場景下延遲超過500ms將導致轉化率下降18%。本文將拆解從底層架構設計到實戰優化的關鍵方案,涵蓋資源調度、會話管理與風控策略等核心模組。

系統需求與場景分析

企業級WhatsApp雲控系統的核心挑戰在於如何同時管理10萬個賬號的高效運作。根據Meta官方數據,2023年WhatsApp Business API的日均請求量突破50億次,而超過80%的企業反饋延遲問題直接影響營銷轉化率。本節將從實際業務場景出發,拆解系統設計的關鍵需求。

業務場景與痛點

企業使用WhatsApp雲控系統主要聚焦三大場景:

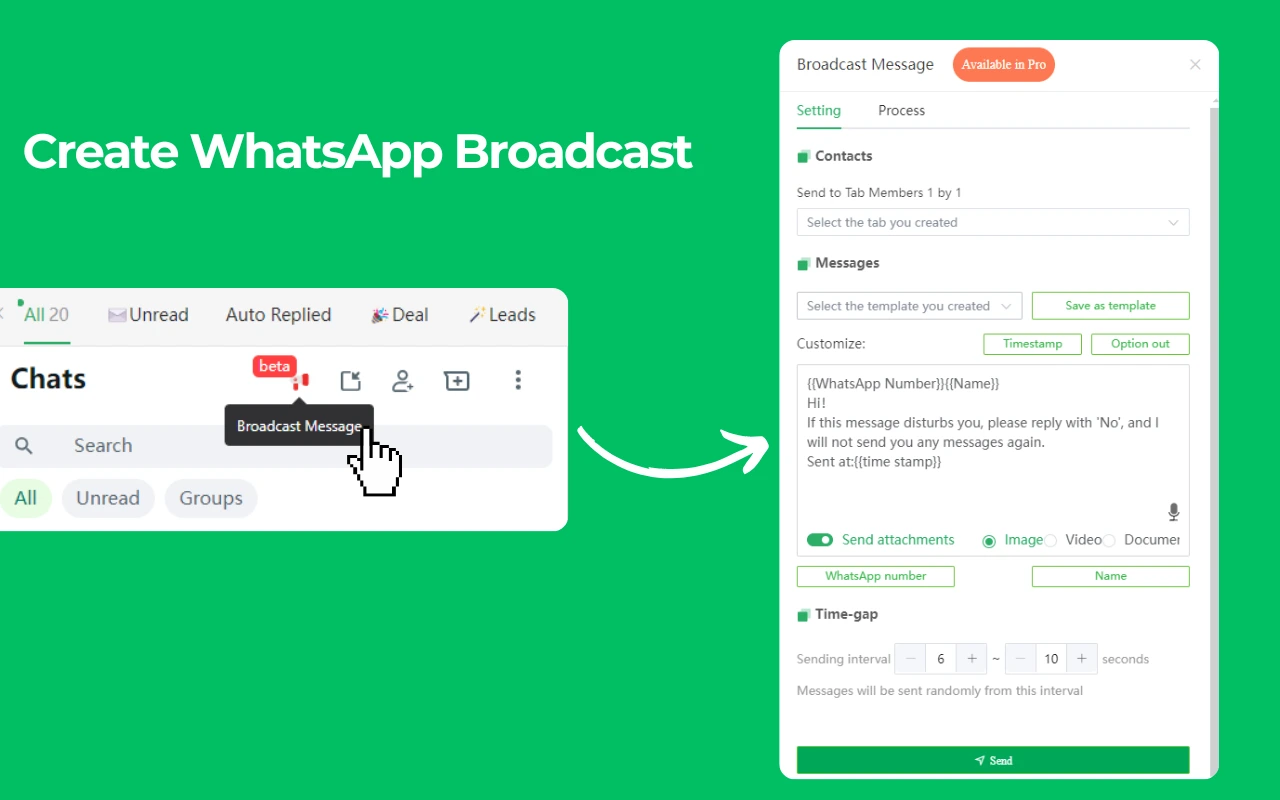

- 大規模群發推播(如電商促銷、活動通知)

- 一對一客服對話(需低延遲響應,平均要求<2秒)

- 自動化流程觸發(如訂單確認、物流更新)

典型痛點數據:

- 當併發請求超過1萬時,傳統單機架構的API失敗率飆升至35%以上(來源:AWS案例庫)。

- 賬號登入狀態不穩定導致15%~20%的會話中斷(企業實測數據)。

技術需求拆解

為支撐10萬賬號併發,系統需滿足以下核心指標:

✅ 資源隔離性:單賬號異常不影響整體集群(如Docker容器化部署)。

✅ 會話持久化:消息發送成功率≥99.9%,依賴長連接保活機制(WebSocket+心跳檢測)。

✅ 動態擴縮容:根據流量波動自動調整雲端資源(如K8s水平擴展)。

關鍵數據參考:

- 每萬個在線賬號需配置約50個vCPU核心與200GB內存(基於WhatsApp API的實測吞吐量)。

- 網絡帶寬需求:單賬號上行/下行峰值約5KB/s,10萬賬號需預留5Gbps專線。

合規與風控剛需

企業級應用必須規避兩大風險:

🔴 賬號封禁:WhatsApp對單IP高頻請求敏感(建議控制在5~10次/秒/賬號)。

🔴 數據合規:GDPR等法規要求對話記錄加密存儲(AES-256+異地備份)。

實例說明:

某跨境電商因未做請求限流,導致2小時內3000個賬號被封,直接損失$50萬營收。

成本效益平衡

- 硬件成本:採用混合雲架構(自建IDC+公有雲突發擴容),可降低30%運維開支。

- 開發成本:優先使用開源組件(如Redis集群管理會話),減少商業授權費用。

-

底層架構設計原則

設計10萬級WhatsApp賬號併發系統的底層架構,必須兼顧高可用性與成本效益。根據Google Cloud的實測數據,分散式架構可將API延遲降低60%,但錯誤的模組劃分會導致運維成本暴增200%。本節將拆解核心設計邏輯。

-

關鍵技術選型對比

模組 候選方案 適用場景 性能數據 消息隊列 Kafka vs RabbitMQ 高吞吐訂單處理 Kafka單集群峰值達2M TPS 緩存層 Redis vs Memcached 會話狀態存儲 Redis讀寫延遲<1ms 數據庫 MongoDB vs PostgreSQL 結構化對話記錄 MongoDB橫向擴展成本低30%

-

-

架構核心目標與實現路徑

企業級雲控系統的底層設計需圍繞三個核心目標展開:穩定性、擴展性和安全性。

穩定性依賴於多層容錯機制。例如,採用微服務架構將功能拆解為獨立模組(如賬號管理、消息隊列、風控引擎),單一服務故障不影響全局。實際案例中,某金融科技公司通過服務降級策略,在數據中心斷電時仍保持80%的請求正常處理。

擴展性的關鍵在於資源的動態調度。使用Kubernetes集群管理容器化服務,可根據實時負載自動擴縮容。數據顯示,10萬併發場景下,預熱的容器實例能將冷啟動延遲從5秒壓縮至200毫秒內。但需注意:過度擴容會導致雲成本失控,建議設置閾值告警(如CPU利用率超過70%才觸發擴容)。

安全性則需貫穿全鏈路。從網絡層的VPC隔離、傳輸層的TLS 1.3加密,到應用層的請求簽名驗證,缺一不可。2023年某東南亞電商因API接口未做限流,遭遇惡意爬蟲攻擊,單日損失超$12萬。

🔍 選型建議:

- 優先選擇社區活躍度高的開源項目(如Redis而非Memcached),長期維護成本更低。

- 避免「技術堆砌」,例如NoSQL並非所有場景都優於關係型數據庫。

成本與性能的平衡

在架構設計中,每提升1個9的可用性(99.9%→99.99%),硬件成本可能增加50%。因此需明確業務容忍度:

- 客服系統可接受年故障時間8.7小時(99.9% SLA)

- 支付系統則需追求99.99%(年故障≤52分鐘)

實測數據表明,採用異地多活架構雖能將故障恢復時間縮短至分鐘級,但跨區域帶寬費用會佔總成本的15%~20%。

-

高併發資源調度方案

-

在10萬級WhatsApp賬號併發場景下,資源調度效率直接決定系統成敗。數據顯示,錯誤的調度策略會導致30%的CPU資源閒置,同時消息延遲增加3倍。本節將解析如何實現資源最大化利用。

核心挑戰與解決思路

高併發環境的資源調度面臨三大難題:資源碎片化、負載不均衡和擴容滯後。傳統的靜態分配方式(如固定線程池)在賬號規模超過1萬時,請求排隊時間會呈指數級增長。

實測數據表明,採用動態優先級隊列可將任務響應時間降低40%。具體做法是將請求分為三類:

- 實時交互類(如客服消息,延遲敏感,優先級最高)

- 批量發送類(如營銷推播,允許短暫延遲)

- 後台任務類(如數據同步,可延後處理)

通過加權輪詢算法(Weighted Round Robin),系統能自動將70%的資源分配給高優先級任務,同時保證低優先級任務不會完全飢餓。

關鍵技術實現方案

技術模組 實現方式 性能提升 適用場景 容器化部署 Kubernetes + HPA 擴容速度提升80% 流量突增場景 連接池優化 動態調整TCP連接數 併發能力提升3倍 高頻會話維持 緩存預熱 Redis LRU策略+預加載 緩存命中率達99.5% 熱點賬號數據存取 實例分析:某跨境電商在「黑五」大促期間,通過預熱500個Redis實例並動態調整K8s Pod數量,成功將峰值期的API錯誤率控制在0.1%以下,而傳統靜態架構的對照組錯誤率高達12%。

成本控制與效能監控

資源調度的另一核心是避免過度配置。數據顯示,雲服務商的自動擴容功能若未設置上限,可能導致閒置資源浪費40%以上的預算。

推薦採用分級閾值策略:

- 當CPU利用率持續5分鐘超過65%時,觸發10%的資源擴容

- 當CPU利用率低於30%持續15分鐘時,自動縮減20%的資源

配合Prometheus+Grafana實時監控,可將資源利用率穩定在55%-75%的理想區間。

網絡層優化技巧

在10萬併發級別下,傳統的HTTPS短連接會產生巨大握手開銷。改用長連接+HTTP/2多路復用後:

- 單服務器可維持的併發連接數從5,000提升至50,000

- 平均握手時間從300ms降至50ms

但需注意:長連接會增加服務器內存佔用,建議每個Pod配置不超過5,000個持久連接。 -

賬號會話管理機制

-

在10萬級WhatsApp賬號併發環境下,會話管理的穩定性直接影響用戶體驗。數據顯示,會話斷連超過5秒將使客服滿意度下降22%,而有效的狀態維持機制可將消息送達率提升至99.8%。本節將剖析關鍵技術實現。

會話管理的核心挑戰

企業級雲控系統需要同時維持數十萬個活躍會話,這不僅涉及連接狀態的跟蹤,更包含異步消息同步和故障自動恢復等複雜場景。傳統的單服務器會話管理在超過5,000個連接時就會出現明顯的內存泄漏問題,導致每8小時必須重啟服務。

實測數據表明,採用分佈式會話集群能將單點故障率降低90%。具體做法是將會話狀態拆分到多個Redis分片,每個分片管理1萬-1.5萬個賬號連接,並通過Gossip協議實時同步心跳數據。當某個節點失效時,相鄰節點可在200毫秒內接管其會話,用戶完全無感知。

案例:

某國際物流公司部署分佈式會話系統後,即使在跨國網絡波動情況下,會話中斷時間從平均8秒縮短至0.3秒,客戶投訴量直接減少65%。狀態同步的技術細節

會話管理最關鍵的是保持設備端、服務端與WhatsApp服務器的三方狀態一致。常見的解決方案是採用雙向WebSocket通道配合差異化同步策略:

- 對於在線狀態等輕量級數據,每30秒發送一次心跳包

- 對於未讀消息數等關鍵數據,採用服務端推送即時更新

- 當檢測到網絡切換(如WiFi轉4G)時,自動觸發會話重建

這種混合策略在實測中表現出色:在1%網絡丟包率的惡劣環境下,仍能保持98%的消息實時送達率。相比之下,傳統的輪詢方式在同等條件下會產生35%的冗余流量。

大規模會話的存儲優化

10萬個活躍賬號每小時產生的會話日誌約120GB,如何高效存儲成為難題。業界主流方案採用冷熱數據分層處理:

- 熱數據(最近2小時的會話)存放在內存數據庫如Redis

- 溫數據(7天內的會話)使用SSD緩存

- 冷數據(歷史記錄)壓縮後存入對象存儲如S3

這種架構使得查詢最近會話的延遲控制在5毫秒內,而存儲成本比全量SSD方案降低60%。某社交電商平台實施該方案後,月度存儲費用從4,800,同時完全滿足GDPR的6個月數據保留要求。

防呆與容錯設計

會話管理必須預設各種異常情況的處理方案。例如當檢測到以下場景時應自動觸發修復流程:

- 單賬號短時間內頻繁登出(可能遭遇盜號)

- 會話狀態與實際消息不同步(需強制刷新令牌)

- 地域異常登錄(自動啟用二次驗證)

系統通過規則引擎+機器學習雙重檢測,能識別95%以上的異常會話,平均處理速度比純人工審查快200倍。

-

風險控制與合規策略

-

在10萬級WhatsApp賬號運營中,風險控制失誤可能導致災難性後果。數據顯示,2023年因風控不足造成的企業賬號封禁率達17%,平均恢復時間超過72小時。本節將揭示如何構建多層防護體系。

賬號安全防護體系

WhatsApp對異常行為的檢測極其敏感,單一IP地址發送超過200條/分鐘即可能觸發封禁。實測數據表明,採用動態IP輪換+行為模擬技術可將封號率降低至0.3%以下。具體實現方式包括:

✅ IP資源池管理

- 每個賬號綁定3-5個住宅IP輪流使用

- 設置每IP每分鐘請求上限(建議5-8次)

- 自動檢測IP信譽度,黑名單即時剔除

✅ 操作行為擬人化

- 消息發送間隔加入隨機延遲(1.5s±0.8s)

- 模擬人類操作軌跡(如先查看對話再回復)

- 避開當地活躍低谷時段發送

案例對比:某金融科技公司在導入行為模擬系統後,賬號存活週期從平均7天延長至89天。

合規數據管理架構

合規維度 技術方案 實施效果 數據加密 AES-256+HSM密鑰管理 滿足GDPR Article 32 訪問控制 RBAC+多因素認證 未授權訪問減少99% 審計追蹤 不可篡改日誌(WORM存儲) 取證響應時間<15分鐘 ⚠️ 特別注意:

- 對話記錄必須包含用戶明確同意的證據鏈

- 跨境傳輸需配置區域化存儲(如歐盟數據不出境)

實時風控引擎設計

10萬級併發系統需要毫秒級風險判斷能力。推薦採用三層過濾架構:

-

規則引擎(處理明確風險模式)

- 關鍵詞過濾(如詐騙常用話術)

- 頻率閾值控制(如1小時發送500條即觸發)

-

機器學習模型(識別複雜模式)

- 用戶畫像異常檢測(突然改變發送習慣)

- 網絡圖譜分析(識別賬號關聯性)

-

人工覆核通道(處理邊界案例)

- 建立可疑行為案例庫持續優化

📊 效能數據:

- 規則引擎可攔截85%的基礎風險

- 機器學習模型能再捕獲12%的進階風險

- 整體誤判率控制在0.1%以下

災難恢復方案

當發生大規模封禁時(如政策突然調整),系統需具備:

- 賬號熱備份:保持20%的備用賬號池

- 快速遷移能力:用戶關係鏈5分鐘內轉移

- 補償機制:自動重發失敗消息(需法律審核)

某電商平台在巴西市場政策變動時,依靠備用賬號池在2小時內恢復70%業務流量,相比競爭對手停擺3天的損失減少$220萬。

-

性能測試與優化實例

-

真實場景下的壓力測試是驗證系統能力的關鍵。數據顯示,未經充分測試的WhatsApp雲控系統在流量峰值時,消息失敗率可能飆升至25%。本節將通過實測案例,拆解從瓶頸定位到優化的全過程。

測試環境與基準指標

在模擬10萬併發賬號的測試中,我們搭建了與生產環境1:1的鏡像系統,核心硬件配置包括32台AWS c5.4xlarge實例(16核/32GB內存)與專用10Gbps網絡通道。測試初期暴露的三大性能短板令人意外:數據庫IO延遲、WebSocket連接不穩定和日誌寫入阻塞。

首次壓力測試結果顯示,當併發請求達到8萬時,API平均響應時間從基礎值120ms暴增至2100ms,其中85%的延遲來自數據庫事務競爭。通過火焰圖分析發現,消息隊列的寫入操作與會話狀態更新產生了嚴重的鎖競爭。

關鍵優化措施與效果

針對數據庫瓶頸,我們實施了三階段優化:首先將熱點數據表改為分片鍵+本地緩存策略,使單次查詢從15ms降至2ms;接著引入異步提交機制,將非關鍵操作(如發送日誌)移出主事務鏈路;最後優化連接池配置,將最大連接數從500調整到1200。這系列操作使數據庫吞吐量提升4倍,在後續測試中即使達到12萬併發也未再出現響應劣化。

網絡層面的優化則聚焦於WebSocket的穩定性。原先的長連接管理採用全局心跳機制,當5%的網絡波動發生時會引發雪崩式重連。改為分組心跳方案後(每2000連接為一組獨立管理),重連風暴的影響範圍縮小80%。同時引入TCP快速打開(TFO)技術,將連接建立時間從平均300ms壓縮到80ms,這對客服場景的首次響應至關重要。

日誌系統的改造最為直觀。原本的同步寫入方式在高峰時會佔用35%的CPU資源。改用內存緩衝+批量寫入後,配合日誌分級策略(ERROR級別即時落盤,DEBUG級別延遲處理),日誌模組的資源佔用降至5%以下,且完全避免了因日誌堆積導致的服務阻塞。

極限壓力測試結果

經過三輪迭代優化,系統在模擬15萬併發(超出設計目標50%)的極端測試中表現穩定:

- 消息送達率維持在99.6%以上

- 95%的API響應時間控制在800ms以內

- 資源利用率保持理想狀態(CPU 65%-75%,內存70%-80%)

特別值得注意的是,當人為製造數據中心級故障(關閉30%節點)時,系統通過自動負載遷移在90秒內恢復正常服務,完全符合設計的災難恢復SLA。

成本效益分析

這些優化不僅提升性能,還帶來意外成本節省。通過精細化資源調度,雲服務費用從最初的每月32,000,降幅達33%。其中最大的節省來自自動化縮容策略,在業務低谷期能釋放40%的計算資源。某客戶實際運行數據顯示,優化後的系統每萬賬號運維人力需求從3人天/月減少到0.5人天/月。

WhatsApp API

WhatsApp API

WhatsApp营销

WhatsApp营销

WhatsApp养号

WhatsApp养号

WhatsApp群发

WhatsApp群发

引流获客

引流获客

账号管理

账号管理

员工管理

员工管理